Propuesta de un banco de ítems para el desarrollo de exámenes que cumplan con los estándares exigidos por el SICELEMartha Jurado Salinas

Coordinadora del proyecto CIE. Centro de Enseñanza para Extranjeros-UNAM (México)

1. Introducción

En la última década, principalmente en los países y los sectores más expuestos a los efectos de la integración regional y la mundialización, se ha multiplicado la creación de diplomas y certificados otorgados con base en la aplicación de instrumentos que evalúan competencias lingüísticas adquiridas independientemente de cualquier instrucción formal específica. Estos sistemas de certificación son valorados, como cualquier otro bien o servicio, en términos de su calidad, puesto que se enfrentan a una mayor competencia, a una gama más amplia de usos y a un público más heterogéneo e impredecible.

En relación con la lengua española, el fenómeno de la certificación de habilidades lingüísticas es relativamente reciente y se ha manifestado básicamente en la creación de instrumentos de evaluación con diversos niveles de calidad, pero carentes todos ellos de una descripción de referencia común de competencias (Varela, 2003).

Ante tal panorama, instituciones como el Instituto Cervantes y la Universidad Nacional Autónoma de México impulsaron en 2005 una iniciativa para crear el Sistema Internacional de Certificación del Español como Lengua Extranjera (SICELE), organismo cuyo objetivo es asegurar la calidad, la transparencia y la coherencia de los certificados a él adheridos y garantizar el cumplimiento de una serie de parámetros de calidad en cuanto a los procedimientos de certificación del dominio de la lengua española y la correlación de niveles de competencia y capacitación de los evaluadores, así como en cuanto a la corrección, calificación, validez y fiabilidad de las pruebas.

El SICELE es un sistema de certificación regido por principios básicos fundamentados en tres aspectos:

El tratamiento de la lengua y de sus variedades en los instrumentos de evaluación; la metodología de trabajo para el desarrollo, confección y calificación de pruebas de examen siguiendo patrones de calidad reconocidos y aceptados internacionalmente por la comunidad académica y por la sociedad civil; y la coherencia de los documentos de información sobre resultados y de calificación.

(SICELE, 06/06/06: 2).

En esta ponencia se describen las características de un software cuyo uso constituye en sí una «metodología de trabajo para el desarrollo, confección y calificación de pruebas de examen siguiendo patrones de calidad reconocidos y aceptados internacionalmente» (como establecen los principios del SICELE); es decir, su aplicación podría apoyar la creación, por parte de las instituciones universitarias hispanoamericanas adheridas a dicho sistema, de instrumentos de evaluación que cumplan con los estándares propuestos por organismos internacionales como la Association of Language Testers in Europe (ALTE), la International Language Testing Association (ILTA), la European Association for Language Testing and Assessment (EALTA), la American Council on the Teaching of Foreign Languages (ACTFL), etcétera. Instrumentos de evaluación con estas características, a su vez, facilitarían la armonización de sistemas de acreditación de competencias lingüísticas, la comparación de certificaciones lingüísticas por parte de consorcios internacionales y el establecimiento de un sistema de reconocimiento mutuo de las certificaciones de conocimientos de lenguas, lo cual, a su vez, facilitaría la movilidad educativa y profesional.

2. Características de una base de ítems o reactivos1

1. Estructura y funcionamiento

Como se describe en el documento de ALTE (2006), un banco de ítems o reactivos «es una manera de almacenar ítems de forma organizada, permitiendo elegir los ítems que coincidan con las especificaciones exactas de un examen concreto fácil y rápidamente» (ALTE, 2006: 60).

Un banco de esta naturaleza tiene la ventaja de que permite almacenar materiales que se pueden utilizar en la generación de diversos exámenes, no solo de uno concreto.

De manera general, la estructura y el funcionamiento de un banco de ítems obedece al siguiente esquema:

Como puede apreciarse en el esquema, hay dos fases fundamentales y son tres los perfiles de usuario: redactores, revisores y superadministrador. El funcionamiento en la primera fase es el siguiente:

- Depósito en el banco por parte de creadores identificados por una clave de acceso.

- Revisión de los reactivos depositados por parte del comité correspondiente. Si el reactivo no pasa la revisión preliminar, se devuelve al autor con observaciones para que este lo modifique; si el reactivo solamente requiere de modificaciones menores (mecanográficas, precisiones léxicas, etcétera), el mismo comité revisor las realiza y el reactivo ingresa al banco preliminar; el sistema tiene la capacidad de auditar y modificar aspectos de formato (tipo de letra, uso de negritas, subrayado, etcétera).

- Una vez que el reactivo ingresa a la base preliminar, los comités de redacción y de revisión solamente tendrán privilegios de lectura; la única persona que tiene privilegios de modificación es el superadministrador.

La primera fase arroja índices de acuerdo con el enfoque psicométrico de la teoría clásica de la evaluación: dificultad,2 discriminación u homogeneidad3 y análisis de los distractores.4 El sistema valida estos índices mediante un código de colores, semejante al de un semáforo. 5

A partir del momento en que el reactivo entra en la fase preliminar, va dejando su traza, es decir, cada una de las modificaciones que sufre son registradas junto con el perfil del usuario que las realizó.

En la segunda fase6 se generarán las distintas versiones de un examen tipo que serán enviadas al sistema de administración de exámenes.

Después de la apsicación a muestras amplias, los ítems se analizarán utilizando el enfoque psicométrico de la Teoría de respuesta a los ítems (TRI). 7 Hay que aclarar que este análisis no se realizará en el banco de reactivos, donde solo se registran los índices, sino en el módulo de aplicación (cuyo desarrollo corresponde al I. C.).

Los ítems que se almacenen en la base definitiva se encontrarán ya calibrados; esto quiere decir que su índice de dificultad estará expresado en una sola escala de medida. De esta manera, el rendimiento de un candidato en una prueba generada a partir de este banco se podrá expresar en términos de su ubicación en esta escala, la cual define tanto la dificultad del ítem como la capacidad de la persona.

2. Sistema de atributos y procedimiento de inserción de los reactivos en el banco

Los atributos son las características que se emplean para describir los materiales de examen. Pueden referirse a los ítems, a los textos, a los gráficos o a cualquier otra característica de un material que necesita ser documentada. Los atributos pueden ser números o palabras, y se puede especificar la validación .

(ALTE, 2006: 62).

Algunos de los atributos numéricos ya se mencionaron en la sección anterior, en relación con los índices de la teoría clásica y de la TRI. En cuanto a los atributos verbales, la mayoría corresponde a campos que el creador debe llenar al ingresar sus ítems. La información básica que debe especificar es: a) el examen en que deposita sus reactivos (se generan varios con el mismo banco); b) la habilidad (o destreza); c) el número de reactivos que se depositan, y d) el tipo de pregunta (en algunos casos, este campo se activa automáticamente, cuando ya han sido seleccionados el examen y la habilidad).

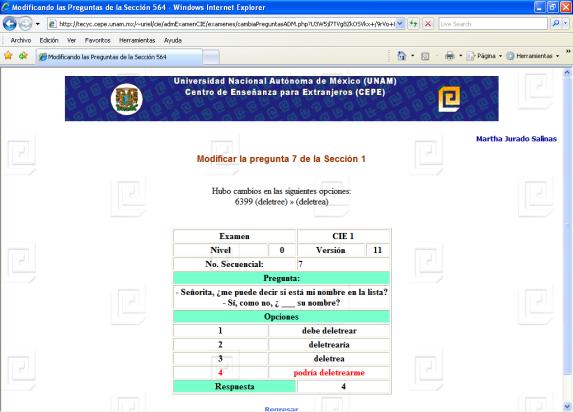

Una vez especificados estos campos básicos, el creador procede a la inserción de los reactivos siguiendo una lógica de navegación que el mismo sistema va guiando, dependiendo de los campos seleccionados previamente. Para depositar reactivos en el Certificado Internacional de Español (CIE), por ejemplo (diseñado fundamentalmente con preguntas de opción múltiple), se insertan primero las raíces (tronco o base) de todos los ítems (puede ser por tecleo directo o mediante el sistema de copiar y pegar desde un texto de word); posteriormente se introduce el texto de las opciones de cada una de las raíces (puesto que el CIE tiene solo ítems con cuatro opciones, aparecen por defecto cuatro campos).

En esta misma sección se deben llenar los campos correspondientes a los atributos de respuesta, homoclave e incompatibilidad con algún otro ítem (debido a que pueden contener información que induzca recíprocamente las respuestas correctas, aunque esto sucede principalmente con los ítems extrínsecos dependientes de un solo texto, característico de las habilidades de comprensión de lectura y de comprensión auditiva).

La homoclave constituye el recurso fundamental con el que se identifica cada uno de los reactivos para su recuperación. Por ejemplo, la homoclave para los reactivos de comprensión auditiva del examen CIE se asigna con base en la siguiente información:

Para la formulación de la homoclave, los creadores pueden auxiliarse de las instrucciones que aparecen en la guía impresa denominada Lineamientos generales para la elaboración de reactivos y consignas del examen CIE.8 En ella también aparecen las tablas de especificaciones. La información puede ser asimismo consultada en documento PDF que se despliega en la pantalla.

Para los reactivos de comprensión de lectura, se deben especificar 9 también atributos relativos al texto base: fuente, tipo de texto: tipo de discurso, extensión (en número de palabras), temática y dificultad. Para la comprensión auditiva se deben especificar atributos relativos al guión y a la grabación: fuente, tipo de discurso, tipo de intercambio, extensión (en minutos), temática y dificultad.

Las tareas de expresión escrita y oral se registran con base en atributos como: tipo de tarea, ámbito, funciones esperadas y temática.

3. Conclusiones

Además de un sistema de recogida de información sobre el rendimiento de los ítems (para poderlos calibrar) y de los métodos estadísticos para estimar su dificultad anclándolos a una sola escala (mediante la TRI), un tercer requisito para confeccionar pruebas de examen mediante un banco es el desarrollo de un sistema de almacenaje y recuperación eficaz (ALTE, 2006: 61).

El primer requisito se resuelve en el módulo de pilotaje mediante la experimentación; el segundo, mediante el análisis de Rash proporcionado por la TRI; para el sistema de almacenaje y recuperación hace falta el desarrollo de un software que organice la información pertinente.

En esta ponencia se describieron las características del banco de ítems, el software y los atributos de un sistema que la UNAM desarrolla para el proyecto CIE, un examen que aspira a ser reconocido y certificado por el SICELE, por cumplir con todos los estándares propuestos por organismos internacionales que se dedican a la evaluación.

Largo, difícil y costoso ha sido para la UNAM este desarrollo para garantizar el cumplimiento de los estándares; sin embargo, consideramos que el camino avanzado podrá servir para que otros países de Hispanoamérica adheridos al SICELE puedan avanzar a mayor velocidad en la importante tarea de diseñar exámenes de calidad que reivindiquen la presencia mundial del español en el ámbito de la certificación de lenguas.

Nota de reconocimientos

Esta ponencia representa el trabajo colectivo del grupo académico del Centro de Enseñanza para Extranjeros de la UNAM que, desde septiembre de 2005, labora en el proyecto CIE. El equipo está integrado por: Eva Campos Gómez, Rosa Esther Delgadillo Macías, Beatriz Granda Dahan, Martha Jurado Salinas, Patricia Martínez Ávila y Rodrigo Polanco Bueno.

Bibliografía

- ALTE Handbook of European Language Examinations and Examination Systems (1998), The University of Cambridge Local Examinations Syndicate.

- Contreras, Carlos (1997): Manual básico de elaboración de reactivos, UNITEC.

- Eguiluz Pacheco, Juan y Ángel Eguiluz (2004): «La evaluación de la expresión escrita», Vademécum para la formación de profesores. Enseñar español como segunda lengua (L2)/lengua extranjera (LE), Madrid: SGEL.

- —(2004): «La evaluación de la comprensión lectora», Vademécum para la formación de profesores. Enseñar español como segunda lengua (L2)/lengua extranjera (LE), Madrid: SGEL.

- Muñiz, J., et al. (2005): Análisis de los ítems, Madrid: La muralla (Cuadernos de estadística).

Documentos electrónicos

- Campos Gómez, et al.(2006): Lineamientos generales para la elaboración de reactivos y consignas, DR. UNAM (Documento interno).

- Circular de la Comisión académica del SICELE, 06/06/06.

- Directrices de ALTE para los creadores de reactivos (1995, actualizado en julio de 2005). Versión española: Instituto Cervantes, 2006. Trad. José Ramón Parrondo.

- Lineamientos básicos para la edición de reactivos, Dirección General de Evaluación Educativa, UNAM (Documento interno).

- Propuesta de parámetros y criterios de valoración mínimos exigibles por parte del SICELE para la certificación de un examen de acreditación del idioma español. Documento presentado por el equipo CIE de la UNAM en la reunión de la Comisión Ejecutiva del SICELE, celebrada en Bogotá en junio de 2006.

Referencias en Internet

- Marco de Referencia Europeo para el aprendizaje, la enseñanza y la evaluación de lenguas.

- Centro Virtual Cervantes; http://cvc.cervantes.es/obref/marco/. Consultado: 20/11/06.

- Varela, Lía: Las certificaciones de conocimientos de lenguas en los países iberoamericanos. Panorama actual y perspectivas. Proyecto CERTEL. OEI: 2003. http://www.oei.es/certel.htm. Consultado: 20/09/06.

- Consejo de Europa: Manual for Relating Language Examinations to the Common European Framework of Reference for languages: Learning, Teaching, Assessment. http://culture2.coe.int/portfolio/inc.asp?L=E&M=$t/208-1-0-1/main_pages/../documents_intro/Manual.html. Consultado: 04/19/04.

Notas

- 1.

La información que aquí se presenta describe el modelo que desarrolla actualmente la Dirección General de Servicios de Cómputo Académico (DGSCA), de la Universidad Nacional Autónoma de México (UNAM), dentro del proyecto Certificado Internacional de Español (CIE), el cual tiene como objetivo crear un examen automatizado de dominio del español, dirigido al ámbito académico.

Dentro del proyecto CIE, a la UNAM corresponde el desarrollo científico del examen y al IC la aplicación en sus diferentes centros. Ambas instituciones comparten responsabilidades en cuanto al desarrollo tecnológico del proyecto. A la UNAM corresponde el desarrollo del módulo de almacenamiento y pilotaje de reactivos, y el de generación de exámenes. Al IC corresponde el desarrollo del módulo de gestión administrativa y aplicación computarizada del examen.

- 2.

En términos generales, el índice de dificultad/facilidad (ID) del examen se refiere a la proporción de los examinados que responde al reactivo correctamente. De esta manera, un ID = 1,0 indica que el reactivo es muy fácil (lo responden correctamente todos los examinados), un ID = 0 indica que el reactivo es muy difícil (no lo responde correctamente ningún examinado) y un ID = 0,5 indica un reactivo de dificultad media (la mitad de los examinados lo responde correctamente). El índice de dificultad por sí solo nos dice poco acerca de la calidad del reactivo, pues hay reactivos difíciles de buena calidad, reactivos difíciles de mala calidad, reactivos fáciles de buena calidad y reactivos fáciles de mala calidad. Lo que es importante es saber para quién es difícil y para quién es fácil el reactivo. Un buen reactivo debe ser relativamente fácil para un examinado que domina el contenido evaluado, mientras que debe ser relativamente difícil para un examinado que no lo domina. De esta manera, si tomamos como criterio de dominio del contenido la calificación misma obtenida por cada examinado en el examen, se puede determinar el ID para el grupo con puntajes más altos y el ID para el grupo con puntajes más bajos. Generalmente, se usan el 27 % de los examinados con mayor calificación (grupo superior) y el 27 % de los examinados con menor calificación (grupo inferior). Así pues, se pueden determinar el ID para el grupo superior (IDs) y para el grupo inferior (IDi) por separado. Un buen reactivo deberá tener un IDs superior a 0,7 (el 73 % de los estudiantes competentes lo responden correctamente) y un IDi menor a 0,5 (menos de la mitad de los estudiantes incompetentes lo responden.

- 3.

El índice de discriminación u homogeneidad (IH) es una medida que combina los índices de dificultad para los grupos superior e inferior y nos da un valor que nos indica el grado en el que el reactivo distingue (discrimina) entre quién domina el contenido y quién no. Para el cálculo del IH se trabaja con los grupos superior e inferior descritos en el punto anterior. El IH se calcula mediante la siguiente fórmula:

En la cual IH se refiere al índice de discriminación u homogeneidad, s representa el número de examinados del grupo superior que respondió correctamente al reactivo, i el número de examinados del grupo inferior que respondió correctamente al reactivo, S el total de examinados del grupo superior. Este índice puede tomar valores entre +1,0 y -1,0. Los valores positivos cercanos a 1 indican que el reactivo discrimina muy bien entre los estudiantes competentes e incompetentes. Los valores cercanos a cero indican que el reactivo no discrimina. Es decir, que los estudiantes competentes tienen tanta probabilidad de responder correctamente el reactivo como los incompetentes. Los valores negativos indicarían que el reactivo es más fácil para un examinado incompetente que para uno competente. Generalmente se considera un que un reactivo discrimina satisfactoriamente cuando su IH es superior a 0,3 o 0,4.

- 4.

En el caso de los reactivos de opción múltiple es posible saber de qué manera funciona cada uno de los distractores haciendo el análisis de IH tomando como base cada uno de ellos. En otras palabras, se contabiliza el número de examinados del grupo superior y el número de examinados del grupo inferior que respondieron cada distractor y se calcula el índice de discriminación en cada caso. Idealmente, la función del distractor es atraer la atención de los examinados con un dominio mediocre del contenido, pero no atraer la atención de los examinados competentes. En consecuencia, un buen reactivo debería ser aquel cuya clave fuera elegida con mayor probabilidad por los estudiantes competentes (IH positivo alto) y cuyos distractores fueran elegidos con mayor probabilidad por los estudiantes incompetentes (IH negativo).

- 5.

El código es el siguiente:

Verde: reactivos que pueden usarse sin reservas: Índice de homogeneidad (IH) > 0,4; Índice de discriminación (IDs) > 0,7; Índice de dificultad (IDi) < 0,5).

Amarillo: reactivos que pueden usarse, pero que sería conveniente modificar: (IH < 0,3; IDs < 0,7; IDi > 0,5).

Rojo: reactivos que no deben usarse, aunque pueden mejorarse: IH < 0,2.

- 6.

Esta fase se encuentra todavía en construcción.

- 7.

Tanto la Teoría Clásica de los Tests como la Teoría de respuesta a los Ítems (TRI) son funciones matemáticas que pretenden explicar y predecir las respuestas de los candidatos que se someten a un test. Ambas tienen como objetivo calcular el error generado en la medición de ciertas variables de naturaleza psicológica. «Existen, sin embargo, tres diferencias esenciales entre ambos modelos. Primera, la unidad de análisis en el modelo clásico es el test (X es la puntuación observada en el test), en tanto la unidad de análisis en la TRI es el ítem. Segunda, la TRI incorpora términos al modelo que describen las características de los ítems. Es decir, que las repuestas de los examinados a los ítems van a estar explicadas, no solo por su nivel de habilidad, sino también por las características psicométricas de los ítems. (…) Finalmente, los supuestos sobre los que descansan ambos modelos son radicalmente diferentes» (Muñiz, et al., 2005: 81).

- 8.

Se trata de un documento interno elaborado por el equipo CIE: Campos Gómez et al. (2006): Lineamientos generales para la elaboración de reactivos y consignas, DR. UNAM.

- 9.

Toda esta información se registra mediante combos que despliegan opciones; por ejemplo:

Tipo de pregunta:

- Opción múltiple

- Falso/verdadero

- Relación de columnas

- Ordenamiento de un texto fragmentado

- Respuesta breve

- Llenado de espacios (una palabra)

- Resumen

- Completar resumen

- Reporte en las propias palabras

- Justificación

- Exposición

- Narrativo

- Expositivo

- Descriptivo

- Argumentativo

- Dialógico